OpenAI và Thách Thức Chi Phí Khi Các Mô Hình AI Mở Rộng Theo Cách Mới

Tháng trước, các nhà sáng lập và nhà đầu tư AI đã chia sẻ với TechCrunch rằng chúng ta đang bước vào "thời kỳ thứ hai của các quy luật mở rộng", chỉ ra rằng các phương pháp cải thiện mô hình AI truyền thống đang cho thấy hiệu quả giảm dần. Một phương pháp mới đầy hứa hẹn mà họ đề xuất để duy trì sự tiến bộ là "test-time scaling", và có vẻ đây chính là yếu tố đằng sau hiệu suất của mô hình o3 của OpenAI — nhưng phương pháp này cũng có những hạn chế riêng.

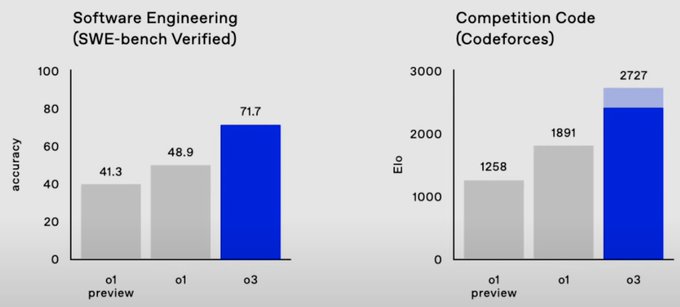

Nhiều người trong giới AI đã xem thông báo về mô hình o3 của OpenAI như một minh chứng rằng tiến bộ trong việc mở rộng AI chưa "vấp phải bức tường". Mô hình o3 thể hiện rất tốt trên các bảng điểm, vượt trội so với tất cả các mô hình khác trong bài kiểm tra về khả năng tổng quát gọi là ARC-AGI, và đạt điểm 25% trong một bài kiểm tra toán học khó mà không mô hình AI nào đạt hơn 2%.

Tất nhiên, chúng tôi tại TechCrunch vẫn thận trọng với tất cả thông tin này cho đến khi có thể tự mình kiểm tra mô hình o3 (hiện tại rất ít người đã thử nghiệm). Tuy nhiên, trước cả khi o3 được phát hành, giới AI đã bắt đầu tin tưởng rằng một điều gì đó lớn lao đã thay đổi.

Noam Brown, đồng sáng lập các mô hình o-series của OpenAI, đã chia sẻ vào thứ Sáu rằng công ty đang công bố những tiến bộ ấn tượng của o3 chỉ ba tháng sau khi họ công bố o1 — một khoảng thời gian khá ngắn cho một bước nhảy vọt như vậy về hiệu suất.

"Chúng tôi có mọi lý do để tin rằng xu hướng này sẽ tiếp tục," Noam Brown chia sẻ trong một bài tweet.

Jack Clark, đồng sáng lập Anthropic, cho biết trong một bài blog vào thứ Hai rằng o3 là bằng chứng cho thấy "tiến bộ AI sẽ nhanh hơn vào năm 2025 so với 2024." (Cần lưu ý rằng việc này có lợi cho Anthropic — đặc biệt là khả năng huy động vốn của họ — nếu giả định rằng các quy luật mở rộng AI vẫn tiếp tục, mặc dù Clark đang khen ngợi một đối thủ.)

Clark cho rằng trong năm tới, thế giới AI sẽ kết hợp giữa phương pháp test-time scaling và phương pháp truyền thống của pre-training scaling để tối ưu hóa hiệu quả hơn nữa từ các mô hình AI. Có lẽ ông đang gợi ý rằng Anthropic và các nhà cung cấp mô hình AI khác sẽ phát hành các mô hình lý luận riêng vào năm 2025, giống như Google đã làm vào tuần trước.

Test-time scaling có nghĩa là OpenAI đang sử dụng nhiều tài nguyên tính toán hơn trong giai đoạn suy luận của ChatGPT, giai đoạn sau khi bạn nhấn Enter để nhập câu lệnh. Cụ thể là OpenAI đang sử dụng thêm các chip máy tính để trả lời câu hỏi của người dùng, sử dụng các chip suy luận mạnh mẽ hơn, hoặc sử dụng các chip này trong thời gian lâu hơn — từ 10 đến 15 phút trong một số trường hợp — trước khi AI đưa ra câu trả lời. Chúng ta không biết tất cả các chi tiết về cách o3 được phát triển, nhưng những chỉ số này là những dấu hiệu ban đầu cho thấy test-time scaling có thể giúp cải thiện hiệu suất của các mô hình AI.

Mặc dù o3 có thể mang lại niềm tin mới cho sự tiến bộ của các quy luật mở rộng AI, nhưng mô hình mới nhất của OpenAI cũng sử dụng một mức độ tính toán chưa từng thấy trước đây, điều này đồng nghĩa với việc giá trả cho mỗi câu trả lời sẽ cao hơn.

"Chắc có lẽ điều quan trọng duy nhất ở đây là hiểu rằng lý do khiến o3 tốt hơn rất nhiều là vì nó tốn nhiều tiền hơn để vận hành trong giai đoạn suy luận — khả năng tận dụng tính toán trong thời gian kiểm tra có nghĩa là trong một số bài toán, bạn có thể biến tính toán thành câu trả lời tốt hơn," Clark viết trong blog của mình. "Điều này thú vị vì nó đã làm cho chi phí vận hành các hệ thống AI trở nên ít dự đoán hơn — trước đây, bạn có thể tính toán chi phí để phục vụ một mô hình sáng tạo chỉ bằng cách nhìn vào mô hình và chi phí tạo ra một đầu ra cụ thể."

Clark và những người khác chỉ ra hiệu suất của o3 trên bảng điểm ARC-AGI — một bài kiểm tra khó dùng để đánh giá các đột phá trong AGI — như một chỉ số cho sự tiến bộ của nó. Cần lưu ý rằng việc vượt qua bài kiểm tra này, theo những người sáng tạo ra nó, không có nghĩa là một mô hình AI đã đạt được AGI, mà đây chỉ là một cách để đo lường tiến trình đến mục tiêu chưa rõ ràng này. Tuy nhiên, mô hình o3 đã vượt qua tất cả các mô hình AI trước đó đã thực hiện bài kiểm tra, đạt 88% trong một trong các lần thử của nó. Mô hình AI tốt nhất tiếp theo của OpenAI, o1, chỉ đạt 32%.

Tuy nhiên, trục x logarithmic trên biểu đồ này có thể gây lo ngại cho một số người. Phiên bản o3 có điểm cao nhất sử dụng hơn 1.000 đô la chi phí tính toán cho mỗi nhiệm vụ. Các mô hình o1 chỉ sử dụng khoảng 5 đô la chi phí tính toán mỗi nhiệm vụ, và o1-mini chỉ tốn vài xu.

Người sáng tạo bài kiểm tra ARC-AGI, François Chollet, viết trong một bài blog rằng OpenAI đã sử dụng khoảng 170 lần lượng tính toán để đạt được điểm 88%, so với phiên bản o3 hiệu quả cao chỉ kém 12% so với điểm cao nhất. Phiên bản o3 có điểm cao nhất sử dụng hơn 10.000 đô la tài nguyên để hoàn thành bài kiểm tra, điều này khiến nó quá đắt để tham gia vào giải thưởng ARC — một cuộc thi chưa có đối thủ dành cho các mô hình AI vượt qua bài kiểm tra ARC.

Tuy nhiên, Chollet cho rằng o3 vẫn là một đột phá đối với các mô hình AI.

“o3 là một hệ thống có khả năng thích ứng với những nhiệm vụ mà nó chưa từng gặp phải, có thể nói là tiếp cận hiệu suất cấp độ con người trong lĩnh vực ARC-AGI,” Chollet viết trong blog. “Tất nhiên, sự tổng quát như vậy đi kèm với một chi phí lớn, và vẫn chưa phải là giải pháp kinh tế: Bạn có thể trả cho một người để giải quyết các nhiệm vụ ARC-AGI với khoảng 5 đô la mỗi nhiệm vụ (chúng tôi biết, chúng tôi đã làm điều đó), trong khi chỉ tiêu tốn một vài xu năng lượng.”

Còn quá sớm để bàn về chi phí chính xác của tất cả những điều này — chúng ta đã thấy giá của các mô hình AI giảm mạnh trong năm qua, và OpenAI vẫn chưa công bố chính thức chi phí thực tế của o3. Tuy nhiên, những con số này cho thấy lượng tính toán cần thiết để phá vỡ, dù chỉ một chút, các rào cản hiệu suất mà các mô hình AI hàng đầu hiện nay đã thiết lập.

Điều này đặt ra một số câu hỏi. o3 thực sự có mục đích gì? Và cần bao nhiêu tính toán nữa để tạo ra thêm sự tiến bộ trong suy luận với o4, o5, hoặc bất kỳ mô hình lý luận tiếp theo nào mà OpenAI sẽ đặt tên?

Có vẻ như o3, hay các phiên bản kế nhiệm của nó, sẽ không phải là "trợ lý hàng ngày" của ai đó như GPT-4o hay Google Search có thể là. Những mô hình này sử dụng quá nhiều tài nguyên tính toán để trả lời những câu hỏi nhỏ trong suốt ngày như, "Làm thế nào để đội Cleveland Browns có thể vào vòng play-off 2024?"

Thay vào đó, có thể các mô hình AI với tính toán thời gian kiểm tra mở rộng sẽ chỉ phù hợp với các câu hỏi lớn như, “Làm thế nào để Cleveland Browns trở thành một đội vô địch Super Bowl vào năm 2027?” Thậm chí, có thể chỉ đáng giá với chi phí tính toán cao nếu bạn là giám đốc điều hành của Cleveland Browns, và bạn đang sử dụng các công cụ này để đưa ra những quyết định lớn.

Các tổ chức có nguồn tài chính mạnh có thể là những người duy nhất có thể đủ khả năng sử dụng o3, ít nhất là trong giai đoạn đầu, như giáo sư Ethan Mollick của Wharton đã chỉ ra trong một tweet.

Chúng ta đã thấy OpenAI phát hành một gói $200 để sử dụng phiên bản o1 với tính toán mạnh mẽ, nhưng theo thông tin, công ty đang xem xét việc tạo ra các gói đăng ký có giá lên đến $2,000. Khi nhìn vào lượng tính toán mà o3 sử dụng, bạn có thể hiểu tại sao OpenAI lại cân nhắc điều này.

Tuy nhiên, có những nhược điểm khi sử dụng o3 cho các công việc có tác động lớn. Như Chollet chỉ ra, o3 không phải là AGI, và nó vẫn thất bại trong một số nhiệm vụ rất dễ mà con người có thể làm một cách dễ dàng.

Điều này không quá ngạc nhiên, vì các mô hình ngôn ngữ lớn vẫn gặp phải vấn đề "hallucination" nghiêm trọng, và o3 cùng với tính toán thời gian kiểm tra dường như chưa giải quyết được vấn đề này. Đó là lý do tại sao ChatGPT và Gemini đều có các cảnh báo dưới mỗi câu trả lời mà chúng đưa ra, yêu cầu người dùng không nên tin vào các câu trả lời một cách mù quáng. Giả sử AGI, nếu nó được đạt đến, sẽ không cần phải có những cảnh báo như vậy.

Một cách để khai thác thêm lợi ích từ test-time scaling có thể là cải thiện các chip suy luận AI.

Có rất nhiều công ty khởi nghiệp đang giải quyết vấn đề này, chẳng hạn như Groq hay Cerebras, trong khi các công ty khác đang thiết kế các chip AI tiết kiệm chi phí hơn, như MatX. Anjney Midha, đối tác tổng quát của Andreessen Horowitz, trước đây đã chia sẻ với TechCrunch rằng ông kỳ vọng các công ty khởi nghiệp này sẽ đóng vai trò lớn hơn trong việc mở rộng test-time scaling trong tương lai.

Mặc dù o3 là một cải tiến đáng kể đối với hiệu suất của các mô hình AI, nhưng nó cũng đặt ra nhiều câu hỏi mới về việc sử dụng và chi phí. Tuy nhiên, hiệu suất của o3 đã củng cố thêm tuyên bố rằng tính toán thời gian kiểm tra là cách tiếp theo để mở rộng mô hình AI trong ngành công nghệ.